L’informatique et les technologies en général sont des domaines complexe à assimiler qui ont été créé et amélioré par de nombreux Hommes.

C'est un domaine qui touche les nouvelles générations et

qui n’existait même pas il y a encore quelques décennies.

Mais le travail de grands noms a influencé ce domaine en découvrant des

phénomènes mathématiques clés.

Pour en citer quelques un:

Grand mathématicien de l’Antiquité grecque dont

Grand mathématicien de l’Antiquité grecque dont

la vie nous est très peu connue, Euclide est

l’auteur du premier véritable livre de mathématiques

de l’histoire, Les éléments. Il y décrit l’un

des plus vieux algorithmes encore utilisés aujourd’hui

: l’algorithme d’Euclide. Celui-ci est

désormais enseigné au collège, et est utilisé

pour l’étude des nombres entiers, l’arithmétique.

Muhammad Mûsâ al-Khwârizmî était membre de la maison de la sagesse de Bagdad. De grands savants

Muhammad Mûsâ al-Khwârizmî était membre de la maison de la sagesse de Bagdad. De grands savants

y œuvraient à traduire les ouvrages des civilisations antiques, afin que l’empire abbasside ait

les moyens d’accomplir son essor. Parmi les nombreux ouvrages savants qu’il avait réalisés, un

allait le rendre célèbre : une synthèse sur les calculs complexes incluant des inconnues, des variables…

Ce livre a introduit en occident le système de numérotation décimale – celui dont l’alphabet va de 0 à 9

– et toutes les règles élémentaires de calcul qui s’y rapportent : ce qu’on appelle aujourd’hui l’algèbre.

Son nom est d’ailleurs à l’origine du terme « algorithme ».

Sa renommée lui a valu de son vivant d’être convoqué par le calife Al’Mamun. Ce dernier voulait entendre de lui

une prédiction sur le temps qui lui restait à vivre. Le savant, fier de cette confiance, prit un ton grave en

fermant les yeux et improvisa une réponse : « Je vois, ô Calife, un très long règne. Déjà vingt années passées,

encore cinquante à venir. » Le Calife Al’Mamun fut ravi. Mais dix jours plus tard, il mourut. Al-Khwârizmî fut ainsi

reconnu comme le père des mathématiques, jamais comme prophète.

L’Angleterre du 19e siècle, et surtout les universités victoriennes ont fourni un certain nombre de mathématiciens précurseurs

L’Angleterre du 19e siècle, et surtout les universités victoriennes ont fourni un certain nombre de mathématiciens précurseurs

qui ont préparé le monde numérique d’aujourd’hui. Parmi eux, George Boole, qui a inventé l’algèbre binaire

en tentant de rattacher le raisonnement logique aux mathématiques, et non plus à la philosophie. Il voulait ainsi

traduire des concepts en formules, leur appliquer certaines lois et ensuite retraduire le résultat en termes logiques.

Ainsi, son algèbre n’accepte que deux valeurs numériques : 0 et 1. 1 désigne une proposition vraie, et 0 une proposition

fausse. Cette algèbre repose sur trois lois : ET, OU, NON. Ces travaux furent d’une grande importance

théorique au 19e siècle. Ils furent aussi d’une grande importance pratique un siècle plus tard avec le développement de

l’informatique. Dans de nombreux langages de programmation, le terme booléen désigne un type de données ne

pouvant prendre que deux valeurs. Et chaque micro-ordinateur fonctionne aujourd’hui à l’aide d’éléments

électroniques réalisant les fonctions ET, OU ou NON, mais aussi NOR ou NAND…

Le père d’Ada Lovelace, le poète anglais Lord Byron, n’étant fait pour être ni un

Le père d’Ada Lovelace, le poète anglais Lord Byron, n’étant fait pour être ni un

mari fidèle ni un père, ce fut sa mère qui assura son éducation, en la destinant à

être mathématicienne ou scientifique, ce qui est inhabituel pour une femme à cette

époque. Sa mère voulut peut-être aussi l’éloigner de toute tentation poétique

pour lui éviter les errements de son père…

En 1832, alors qu’elle n’a que 17 ans, elle rencontre Charles Babbage, qui tente de

construire une machine à calcul : la machine analytique. Ada Lovelace

voit assez rapidement le potentiel d’une telle machine capable de réaliser n’importe

quel calcul, ce qu’on connaît aujourd’hui comme un ordinateur, et en décrit l’impact

avec un siècle d’avance ! Elle rédige une note dans laquelle elle décrit comment

réaliser un calcul mathématique complexe avec la machine, décrivant les étapes à

réaliser, sous la forme de position des rouages de la machine et comment lui permettre

d’arriver à un résultat donné. C’est elle qui a en premier formalisé le principe de

programmation, ce qui fait d’elle la première codeuse au monde !

En perdant Ada Lovelace, qui n’a pas survécu à un cancer, la machine analytique

a probablement perdu sa plus belle chance de voir le jour et, ainsi, de devenir le premier calculateur

mécanique avec un siècle d’avance.

Inventeur français né à Lyon sous l’Ancien Régime pendant le règne de Louis XV, Joseph-Marie Jacquard

Inventeur français né à Lyon sous l’Ancien Régime pendant le règne de Louis XV, Joseph-Marie Jacquard

est fils d’un maître-fabricant en soie. Grâce à son savoir en mécanique et à son éducation dans le milieu

des canuts tisseurs de soie, il conçoit en 1801 un nouveau type de métier à tisser qui porte depuis son nom

: le métier Jacquard. Cette invention permet d’assister les ouvriers pour tisser des motifs compliqués sur le

tissu, à l’aide d’un système complexe d’aiguilles, de crochets guidés par des cartes perforées à l’avance.

Comme le motif obtenu dépend de la carte perforée utilisée, on peut en quelque sorte « programmer » un même

métier Jacquard de différentes manières et obtenir à chaque fois des dessins différents sur le tissu. Ainsi

cette machine est une des toutes premières capables de « lire » une suite d’instructions écrites dans un

« langage machine » et de l’exécuter. Tout comme nos ordinateurs modernes, même si eux peuvent également

modifier les données qu’ils ont en mémoire et appliquer d’autres types d’instructions permettant des

utilisations plus variées.

Les grands noms qui ont réellement permis des avancées dans ce domaine ont vécu au 20ème siècle.

Il y a de grands noms connus même d’un public inculte, comme des petits noms qui ont pourtant eu une grande importance.

D’origine hongroise, ce génie précoce est l’un des nombreux savants d’Europe centrale à avoir émigré

D’origine hongroise, ce génie précoce est l’un des nombreux savants d’Europe centrale à avoir émigré

aux Etats Unis pendant l’occupation nazie. Il s’est intéressé à de nombreuses disciplines, mais en informatique,

on a donné son nom à l’organisation de base des ordinateurs. Cette organisation distingue quatre composantes :

une unité arithmétique et logique qui effectue les opérations de base, une unité de contrôle chargée du séquencement

des opérations, la mémoire qui contient les données et le programme qui commande au traitement de ces données, et enfin

les dispositifs d’entrées et sorties qui permettent à l’ordinateur de communiquer avec le monde extérieur.

La paternité de ses travaux est cependant contestée.Ce n’est pas le seul à avoir travaillé sur la machine

informatique. On le considère aujourd’hui comme l’un des pères de l’ordinateur, avec Turing et bien d’autres…

John Von Neumann a fait partie des savants qui ont participé au développement de la bombe atomique et de la bombe

à hydrogène. C’est d’ailleurs l’exposition aux fortes radiations lors de ses nombreux tests qui a raccourci sa vie.

Employée par la marine américaine pendant la Seconde Guerre Mondiale, elle ne prendra

Employée par la marine américaine pendant la Seconde Guerre Mondiale, elle ne prendra

sa retraite définitive qu’à l’âge de 80 ans ! Grace Hopper a toujours défendu l’idée

qu’un langage de programmation aurait plus de potentiel s’il était plus proche du langage

humain que du langage des machines.

C’est ainsi que Grace Hopper a conçu le premier compilateur. Un programme informatique est

écrit dans un langage très abstrait, mélangeant anglais et mathématique compréhensible par

un humain. Le compilateur va simplement traduire ce langage complexe en langage compréhensible

par la machine. C’est l’intermédiaire, le médiateur.

Grace Hopper est aussi connue pour son franc parler. Sa devise (qui n’est pas d’elle !)

« Il vaut mieux devoir s’expliquer après que demander la permission avant ». Elle faisait

également preuve de talents pédagogiques, en soulignant par exemple que 30 cm de fils électriques

représentaient 1 nano-seconde, ce qui est le temps qu’il faut à une impulsion électrique

pour parcourir les 30 cm.

Alan Turing est un personnage que l’on reconnaît comme un des pères de l’informatique moderne.

Alan Turing est un personnage que l’on reconnaît comme un des pères de l’informatique moderne.

Il a proposé en 1936, avant l’apparition des premiers ordinateurs, une formalisation de la notion

de calcul et de ses limites intrinsèques, toujours pertinente 80 ans après ! Cette formalisation

s’est faite au travers d’une machine abstraite, capable de réaliser n’importe quel calcul. Une machine

à instructions programmable, dont tous les ordinateurs d’aujourd’hui ont hérité. Mais il fut aussi un

homme de son siècle, gravement troublé par la Seconde Guerre Mondiale. Les communications des

sous-marins allemands étaient codées par une machine : la machine Enigma, réputée incraquable.

Or Alan Turing parvint à en percer la clef, et inventa une autre machine qui permit de décoder

jusqu’à 120 messages par heure. On considère aujourd’hui que cet exploit, longtemps resté secret

défense, place Alan Turing comme un acteur essentiel de la débâcle des nazis.

Enfin, Alan Turing a été le témoin et l’acteur du développement des tous premiers ordinateurs,

environ 10 ans après leur formalisation. Il déclara être souvent surpris des capacités réelles

de ces machines pourtant encore très rudimentaires. Cette expérience lui a permis de formaliser

une autre intuition : des mécanismes pourraient un jour se montrer aussi intelligents que l’Homme,

en reproduisant les mêmes résultats que l’activité mentale de l’Homme. Cette idée fait de lui le

père de l’intelligence artificielle. Il a imaginé un test qui désormais porte son nom et qui pourrait

permettre de déterminer si une machine réussit à se faire passer pour un humain. Aujourd’hui,

les ordinateurs, mêmes les plus ordinaires, nous dépassent sur beaucoup de compétences, mais aucun

n’a pu passer le test ! Cependant le risque qu’un ordinateur tente de se faire passer pour un humain

est réel, et les CAPTCHA qui protègent certains sites web sont justement là pour tenter de s’en

prémunir.

En attendant, Alan Turing et ses machines se trouvent aujourd’hui dans notre quotidien, dans nos maisons et dans nos poches !

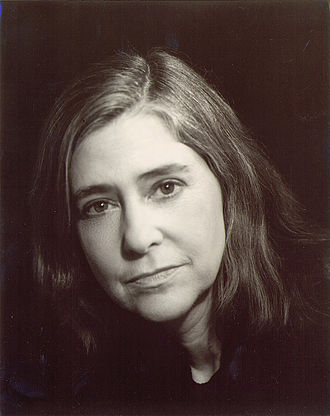

Margaret Hamilton s’est très tôt intéressée à l’informatique et aux mathématiques. Après ses études

Margaret Hamilton s’est très tôt intéressée à l’informatique et aux mathématiques. Après ses études

elle devient programmeuse au sein de plusieurs laboratoires, ce qui la conduit finalement à

travailler avec la NASA pour le projet Apollo visant à envoyer des hommes sur la Lune. C’est Margaret

Hamilton qui était en charge de la conception de tous les logiciels embarqués dans la fusée, elle en

écrira d’ailleurs la majorité du code.

Margaret Hamilton a révolutionné l’ingénierie logicielle et la conception de programmes complexes.

En effet il est extrêmement difficile de construire des logiciels constitués de plusieurs parties

imbriquées, ce qui est le cas des fusées lunaires (le radar, les communications, la gestion des

informations fournies par les capteurs, etc. fonctionnent tous en même temps). De plus tous les

logiciels comportent forcément quelques bugs non détectés qui peuvent potentiellement poser des

problèmes graves s’ils se déclenchent. Margaret Hamilton a pour cela inventé de nouvelles méthodes

permettant de limiter la gravité des défaillances informatiques, en laissant la possibilité soit pour

les humains de reprendre le contrôle, soit pour l’ordinateur de détecter et d’abandonner uniquement

les procédures défectueuses. Ces innovations ont d’ailleurs permis de sauver la mission lorsque le

radar du module lunaire a saturé la mémoire de l’ordinateur de bord.

Ainsi sans les nouvelles techniques de conception logicielle introduites par Margaret Hamilton,

Neil Armstrong n’aurait sans doute pas pu poser le pied sur la lune le 20 juillet 1969. Et les programmes

complexes comporteraient trop de failles pour être utilisables en pratiques.

Né en 1938 aux Etats-Unis, Donald Knuth fait partie des pionniers de l’informatique.

Né en 1938 aux Etats-Unis, Donald Knuth fait partie des pionniers de l’informatique.

Il a notamment beaucoup travaillé sur l’étude des algorithmes et de leur comportement.

Dans son livre le plus célèbre, the Art of Computer Programming, il montre comment

prouver qu’un algorithme ne contient pas d’erreur de conception.

Donald Knuth est aussi l’auteur du programme TeX, qui permet de faciliter la mise en

page de textes scientifiques et est aujourd’hui utilisé dans la plupart des laboratoires.

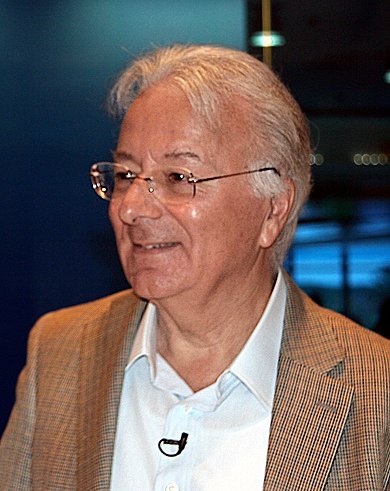

Physicien italien ayant émigré aux Etats-Unis à la fin des années 60,

Physicien italien ayant émigré aux Etats-Unis à la fin des années 60,

il a mis au point le premier microprocesseur commercialisé

par l’entreprise américaine Intel en 1971, le Intel 4004.

Le microprocesseur est un composant électronique qui permet aux ordinateurs

actuels d’exécuter un programme et de traiter des données. Avant

son invention, les ordinateurs devaient être beaucoup plus gros

(de la taille d’une pièce de maison) pour pouvoir fonctionner.

C’est cette invention qui a ouvert la voie à la diffusion large de

l’informatique telle qu’on la connait aujourd’hui, en particulier

dans les maisons et les entreprises.

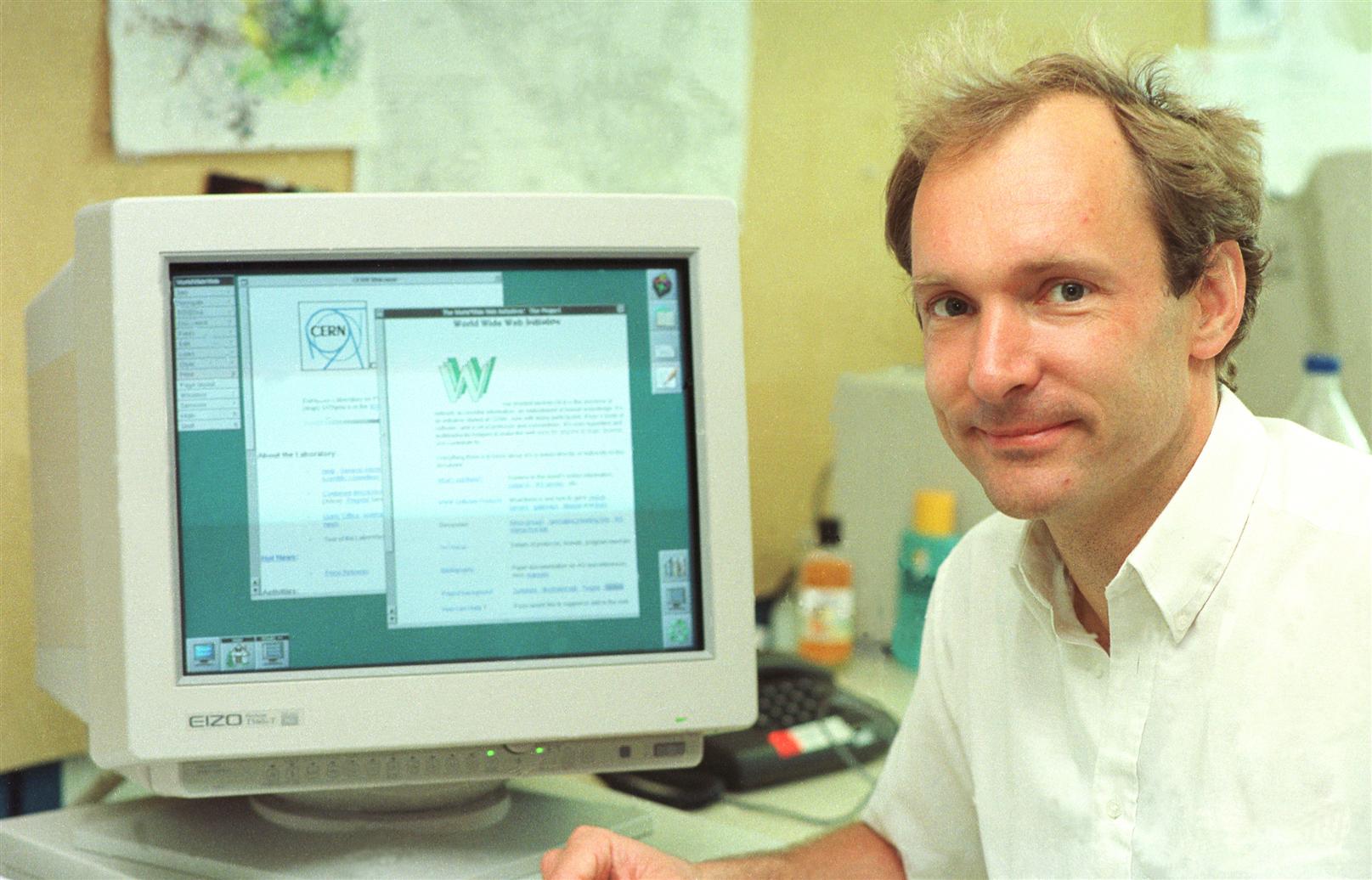

Si vous surfez sur le web avec votre ordinateur, c’est grâce à Tim Berners Lee !

Si vous surfez sur le web avec votre ordinateur, c’est grâce à Tim Berners Lee !

Tout commence au Conseil Européen pour la Recherche Nucléaire : le CERN. Le

chercheur propose de travailler sur l’amélioration du partage de toutes les

informations sur un seul réseau, le but étant de faciliter la communication

instantanée autour des travaux des physiciens et leur permettre d’être en permanence

en contact entre eux, depuis leurs pays respectifs ou au sein du CERN à Genève.

Avec ses recherches, Tim Berners Lee tente de réaliser ce vieux rêve de créer un

réseau dynamique, constitué par un ensemble de documents informatiques liés entre

eux. C’est ce que Ted Nelson aura appelé en 1965 l’Hypertexte, un texte avec des

liens permettant facilement d’aller d’une partie à une autre, d’un mot à sa

définition, d’un paragraphe à une note, d’une section à une autre. Le Web de

Tim Berners Lee c’est tout ça en très simplifié, mais à l’échelle planétaire.

C’est en mai 1990 qu’il baptise son réseau, World Wide Web, la Toile qui couvre

le monde. Une équipe va ensuite se former autour de lui pour améliorer cette

proposition et développer les trois principales technologies du Web : les adresses

web, le protocole de transfert hypertexte (le http), et le langage de balisage

hypertexte (le HTML). Les premiers navigateurs étaient trop puissants pour que

tous les ordinateurs les supportent, mais peu à peu les interfaces ont été

améliorées. Et le Web scientifique s’est peu à peu ouvert pour devenir l’outil

grand-public que nous connaissons aujourd’hui.

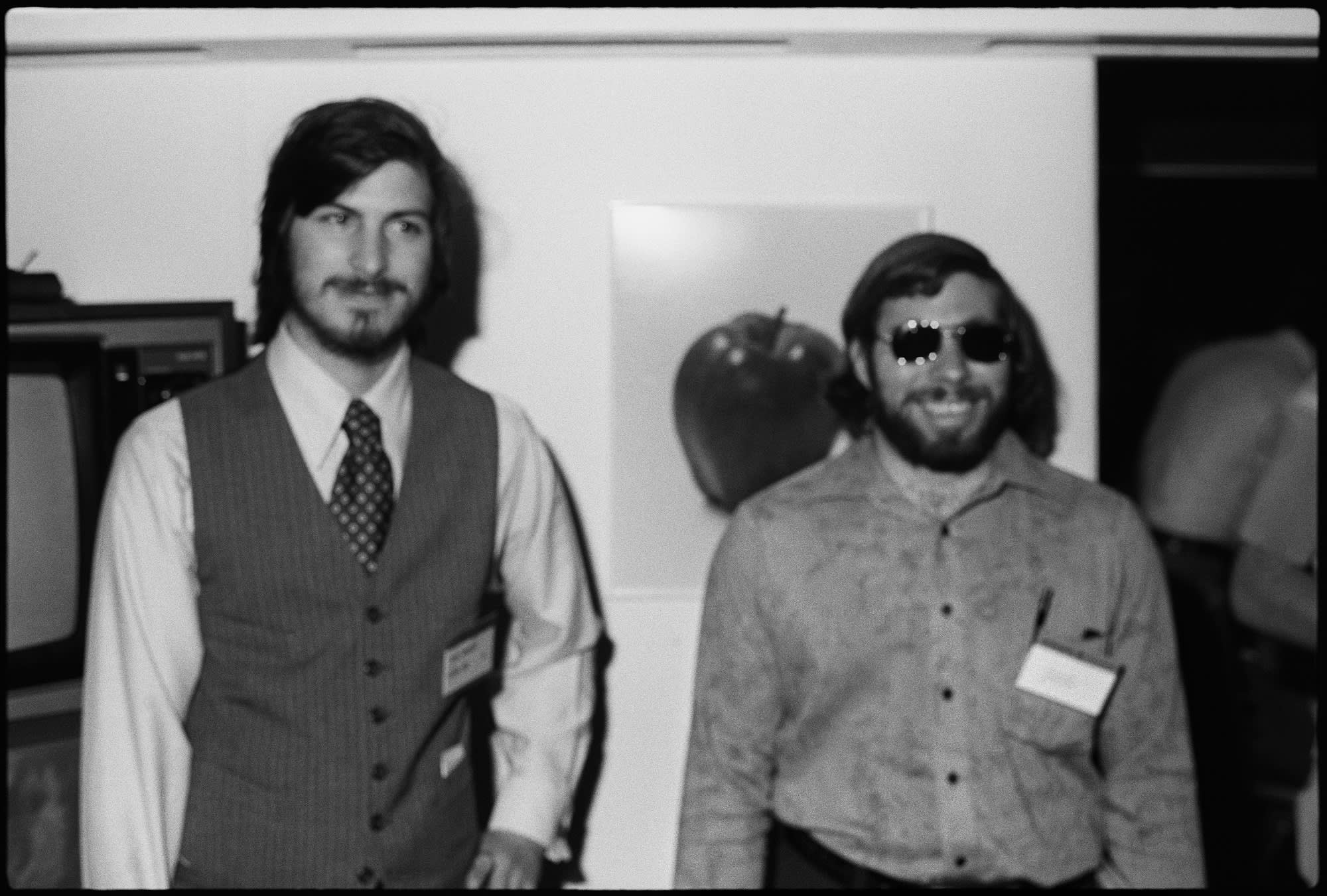

Steve Jobs et Stephen Wozniak étaient justement de ces amateurs qui cherchaient

Steve Jobs et Stephen Wozniak étaient justement de ces amateurs qui cherchaient

un modèle économique pour les ordinateurs personnels. En 1976, ils fondent la

société Apple Computer pour distribuer l’Apple I qu’avait conçu Wozniak et qu’il

assemblait dans le garage de Jobs (ah les garages !). L’Apple I fut suivi de

l’Apple II, mais l’étape suivante la plus importante fut la création du Macintosh

qui reprenait des idées développées par Xerox (les photocopieurs) et que que Jobs

avait pu voir lors d’une visite. Les chercheurs de Xerox avaient du talent pour

inventer un tas de choses, mais leurs patrons avaient du mal à vendre quelque chose

qui ne ressemblait pas à un photocopieur ! Au contraire, Jobs ne s’arrêtait pas à

ses détails, et il comprit vite qu’un Macintosh plus une imprimante faisaient un

excellent poste de travail, d’où la création de l’imprimante laser LaserWriter.

C’était le début d’une histoire assez mouvementée, où Jobs est proprement viré de

chez Apple en 1985, y revient 12 ans après, pour lancer les produits mythiques que

l’on connait, l’iPod, l’iPhone, l’iPad qui ont en commun de ne pas être que des

ordinateurs, de former un écosystème, et de renouveler les modèles économiques

des objets électroniques et de leurs contenus.

Rappelez-vous l’histoire de l’Intel 4004 qui était devenu le favori des hobbyistes

Rappelez-vous l’histoire de l’Intel 4004 qui était devenu le favori des hobbyistes

(pièce du circuit intégré). Un de ses descendants était le processeur Intel 8088.

Au même moment, vers 1980, IBM spécialiste des gros ordinateurs d’entreprise avait

un PDG visionnaire qui voulait entrer sur le marché de l’ordinateur personnel, le

personal computer ou PC. Comprenant que la culture de son entreprise ne l’aiderait

pas il créa une unité quasiment autonome chargée de développer le PC d’IBM, l’IBM PC.

D’habitude, IBM concevait ses ordinateurs de A à Z, du processeur aux logiciels, mais

là, pour aller plus vite, et peut-être aussi pour éviter de retomber dans une action

anti-trust dont il sortait à peine, IBM fit le choix de sous-traiter le processeur et

le logiciel, et de ne spécifier que la façon de les faire fonctionner ensemble. Le

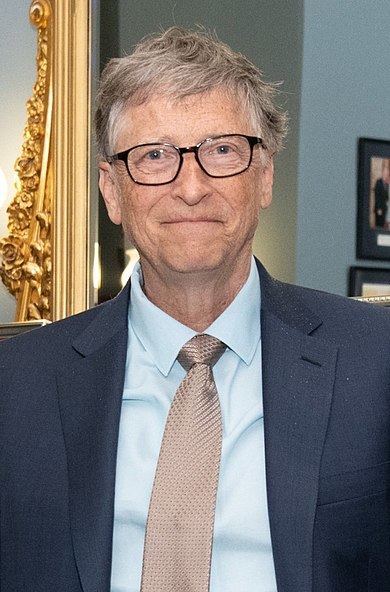

processeur échut à Intel, et le logiciel à Microsoft, une toute petite start-up dirigée

par un inconnu, BillGates. On peut dire que IBM leur avait offert un futur doré sur un

plateau d’argent.